不看后悔「ChatGPT服务器,深度拆解(2023)」服务器tpmc指标服务器tpmc 一般为多少

92份专业报告

ChatGPT发布之后,引发了全球范围的关注和讨论,国内各大厂商相继宣布GPT模型开发计划。据各公司官网,2023年2月7日,百度宣布将推出ChatGPT类似产品“文心一言”,预计今年3月展开内测;2月8日阿里宣布阿里版ChatGPT正在研发中,目前处于内测阶段;2月9日,字节跳动旗下AI Lab宣布正在开展ChatGPT和AIGC相关研发,未来将为PICO提供技术支持;2月10日,京东旗下言犀人工智能平台推出产业版ChatGPT—“ ChatJD”。下载链接:《92份重磅ChatGPT专业报告》计算机专题研究:ChatGPT服务器,深度拆解浙商证券:ChatGPT研究框架 ChatGPT芯片算力:研究框架计算机行业:ChatGPT,深度拆解AI算力模型

AI模型对算力的需求主要体现在训练和推理两个层面。当前主流的人工智能算法通常可分为“训练”和“推理”两个阶段。据IDC数据,2021年中国人工智能服务器工作负载中,57.6%的负载用于推理,42.4%用于模型训练。据IDC预计,到2026年AI推理的负载比例将进一步提升至62.2%。具体来看:

1)训练阶段:基于充裕的数据来调整和优化人工智能模型的参数,使模型的准确度达到预期。对于图像识别、语音识别与自然语言处理等领域的复杂问题,为了获得更准确的人工智能模型,训练阶段常常需要处理大量数据集、做反复的迭代计算,耗费巨大的运算量。

2)推理阶段:训练阶段结束以后,人工智能模型已经建立完毕,已可用于推理或预测待处理输入数据对应的输出(例如给定一张图片,识别该图片中的物体),此过程被称为推理阶段。推理阶段对单个任务的计算能力要求不如训练那么大,但是由于训练出来的模型会多次用于推理,因此推理运算的总计算量也相当可观。

ChatGPT算力需求场景包括预训练、Finetune及日常运营。从ChatGPT实际应用情况来看,从训练+推理的框架出发,我们可以将ChatGPT的算力需求按场景进一步拆分为预训练、Finetune及日常运营三个部分:

1)预训练:主要通过大量无标注的纯文本数据,训练模型基础语言能力,得到类似GPT-1/2/3这样的基础大模型;

2)Finetune:在完成预训练的大模型基础上,进行监督学习、强化学习、迁移学习等二次或多次训练,实现对模型参数量的优化调整;

3)日常运营:基于用户输入信息,加载模型参数进行推理计算,并实现最终结果的反馈输出。

预训练阶段:单次算力需求取决于模型参数量,最高可达3640 PFlop/s-day

ChatGPT基于Transformer架构,进行语言模型预训练。GPT模型之所以能够高效地完成大规模参数计算,我们认为离不开Transformer架构的加持。拆解Transformer架构来看,核心是由编码模块和解码模块构成,而GPT模型只用到了解码模块。拆解模块来看,大致分为三层:前馈神经网络层、编码/解码自注意力机制层(Self-Attention)、自注意力机制掩码层,其中:

1)注意力机制层主要作用在于计算某个单词对于全部单词的权重(即Attention),从而能够更好地去学习所有输入之间的关系,实现对文本内在关系的理解和更大规模的并行计算;

2)前馈神经网络提供了对数据信息的高效存储及检索;3)掩码层在这一过程中帮助模型屏蔽位于计算位置右侧尚未出现的单词。因此,相较于前代深度学习架构RNN,Transformer架构可以实现更大规模的并行计算,大大提升了计算效率。

单一大模型路线下,需要完成大规模参数计算。以GPT-3模型为例,随着模型朝更大体量的方向演进,参数量从GPT-3 Small的1.25亿个增长到GPT-3 175B的1746亿个,一次训练所需的计算量从2.6PFlop/s-day增至3640PFlop/s-day。与此同时,在不同学习样本(包括小样本、单一样本、零样本)条件下的模型,随着参数量的提升均实现不同幅度的上下文学习能力改善,外在表现为语言准确率的提升。我们认为,随着大模型训练表现出越来越强大的实战能力,未来或将成为NLP训练的主流选择。

推理阶段:预计单月运营算力需求约7034.7 PFlop/s-day

ChatGPT近一月访问量为8.89亿次。据SimilarWeb数据,2023年1月以来ChatGPT官网日访问量持续攀升,从1月初的日均千万次级别,到1月底日均两千万次,再到2月中旬的三千万次级别,随着软件效果的广泛传播,用户访问次数愈发频繁。加总近一月(2023/1/17-2023/2/17)ChatGPT官网访问量数据来看,可得ChatGPT月访问量为8.89亿次。

预计日常运营单月所需算力约7034.7 PFlop/s-day。日常运营过程中,用户交互带来的数据处理需求同样也是一笔不小的算力开支。据前文,近一个月(2023/1/17-2023/2/17)ChatGPT官网总访问量为8.89亿次。据Fortune杂志,每次用户与ChatGPT互动,产生的算力云服务成本约0.01美元。基于此,我们测算得2023年1月OpenAI为ChatGPT支付的运营算力成本约889万美元。此外,据Lambda,使用训练一次1746亿参数的GPT-3模型所需花费的算力成本超过460万美元;据OpenAI,训练一次1746亿参数的GPT-3模型需要的算力约为3640 PFlop/s-day。我们假设单位算力成本固定,测算得ChatGPT单月运营所需算力约7034.7PFlop/s-day。

Finetune阶段:预计ChatGPT单月Finetune的算力需求至少为1350.4PFlop/s-day

模型迭代带来Finetune算力需求。从模型迭代的角度来看,ChatGPT模型并不是静态的,而是需要不断进行Finetune模型调优,以确保模型处于最佳应用状态。这一过程中,一方面是需要开发者对模型参数进行调整,确保输出内容不是有害和失真的;另一方面,需要基于用户反馈和PPO策略,对模型进行大规模或小规模的迭代训练。因此,模型调优同样会为OpenAI带来算力成本,具体算力需求和成本金额取决于模型的迭代速度。

预计ChatGPT单月Finetune算力需求至少为1350.4PFlop/s-day。据IDC预计,2022年中国人工智能服务器负载中,推理和训练的比例分别为58.5%、41.5%。我们假设,ChatGPT对推理和训练的算力需求分布与之保持一致,且已知单月运营需要算力7034.7 PFlop/s-day、一次预训练需要算力3640 PFlop/s-day。基于此,我们进一步假设:1)考虑到AI大模型预训练主要通过巨量数据喂养完成,模型底层架构变化频率不高,故我们假设每月最多进行一次预训练;2)人类反馈机制下,模型需要不断获得人类指导以实现参数调优,以月为单位可能多次进行。由此我们计算得ChatGPT单月Finetune算力成本至少为1350.4PFlop/s-day。

1、ChatGPT需要的服务器:AI训练型服务器+AI推理型服务器

随着计算场景扩展,算力硬件也在发生变化。在传统软件架构下,主要的模式都是CS模式,服务端大多是单机处理几千个轻量请求。而在边缘计算场景下,需要数万台服务器处理上亿个重负载请求。边缘计算机本质上是用CES模式取代CS模式,当前的互联网IT架构已经从CS模式,逐步向CDN服务为核心的CES模式转变。但当前的CDN模式比较大的局限性在于缺乏灵活性,不能解决边缘上非结构化数据存储和处理的需求,引入Edge端(边缘端)就是为了解决CS模式下无法处理的业务。而在AI训练场景下,计算量及数据类型的变化导致C-E-S又无法满足集中大算力需求,计算架构回归C-S,并向高效率并行计算演变。

服务器作为算力硬件核心,面向不同计算场景分化演进。我们认为,计算架构的变化是推动服务器技术演进的关键变量。从计算场景来看,随着计算架构从PC到云计算,到边缘计算,再到AI训练,服务器需求也在发生相应变化。从单一服务器更加强调服务个体性能,如稳定性、吞吐量、响应时间等。云数据中心服务器对单个服务器性能要求下降,但更强调数据中心整体性能,如成本、快速部署和交付。边缘计算场景下,开始出现异构计算等复杂环境计算,对数据交互实时性要求有所提升,需要在边缘端设立单独的服务器设施。而AI服务器主要专为人工智能训练设计,数据类型以向量/张量为主,多采用大规模并行计算以提升运算效率。

同一技术路线下,服务器面向数据处理需求持续迭代。复盘主流服务器发展历程来看,随着数据量激增、数据场景复杂化,不同类型服务器发展驱动力也有所差异。具体来看:

1)通用服务器:传统通用服务器的发展与计算机架构发展同步,通过处理器的时钟频率、指令集并行度、核数等硬件指标的提升优化自身性能,发展较为缓慢。

2)云计算服务器:云计算的概念于20世纪80年代提出,仅20年后就有较为成熟的产品推出,如VMware的VMware Workstation和亚马逊AWS等。2010年随着OpenStack开源,阿里云、华为云等项目相继布局,云计算行业快速走向成熟。

3)边缘计算服务器:边缘计算概念孵化于2015年,仅2年后就有诸如亚马逊AWS Greengrass、谷歌GMEC等边缘计算平台产生,并在微软的带领下提前进入技术并购期。

4)AI服务器:AI服务器最早由思科在2018推出,专为人工智能、机器学习的工作服务而设计,硬件架构更加适合AI训练场景下的算力需求。

2、云计算服务器:大规模数据处理需求下的商业模式变革

数据量激增带来大算力需求,云计算服务器应运而生。通用服务器通过提高硬件指标提升性能,而随着CPU的工艺和单个CPU的核心数量接近极限,通用服务器性能难以支持数据量激增带来的性能需求。云计算服务器则通过虚拟化技术,将计算和存储资源进行池化,把原来物理隔离的单台计算资源进行虚拟化和集中化。最终以集群化处理来达到单台服务器所难以实现的高性能计算。同时,云计算服务器集群的计算能力可以通过不断增加虚拟化服务器的数量来进行扩展,突破单个服务器硬件限制,应对数据量激增带来的性能需求。

云计算服务器节约部分硬件成本,降低算力采购门槛。早期大规模数据处理成本极高,原因在于通用服务器的购置和运维成本居高不下。传统服务器中均包含处理器摸块、存储模块、网络模块、电源、风扇等全套设备,而云计算服务器体系架构精简,省去重复的模块,提高了利用率。同时云计算服务器针对节能需求,将存储模块进行虚拟化,并去除了主板上的非必要硬件,降低了整体计算成本,并通过流量计费模式,使得更多厂商可以负担算力开支,降低了算力采购门槛。

3、边缘服务器:高数据密度和带宽限制下保证低时延

边缘计算在云计算的基础上引入边缘层。边缘计算是在靠近物或数据源头的网络边缘侧,为应用提供融合计算、存储和网络等资源。在体系架构上,边缘计算在终端层和云层之间引入边缘层,从而将云服务扩展到网络边缘。其中终端层由物联网设备构成,最靠近用户,负责收集原始数据并上传至上层进行计算;边缘层由路由器、网关、边缘服务器等组成,由于距离用户较近,可以运行延迟敏感应用,满足用户对低时延的要求;云层由高性能服务器等组成,可以执行复杂计算任务。

边缘计算较云计算在实时性、低成本和安全性等方面有优势:

1)实时性:边缘计算将原有云计算中心的计算任务部分或全部迁移到与用户距离更近的网络边缘进行处理,而不是在外部数据中心或云端进行,因此提高了数据传输性能,保证了处理的实时性。

2)低带宽成本:终端产生的数据无需远距离传输至云端,避免带宽成本。同时,边缘计算机制中,边缘层可对终端产生数据进行预处理,从而降低云计算中心的计算负载。

3)安全性:边缘计算在本地设备和边缘层设备中处理大部分数据而不是将其上传至云端,减少实际存在风险的数据量,避免数据泄露危险。

4、AI服务器:更适合深度学习等AI训练场景

AI服务器采取GPU架构,相较CPU更适合进行大规模并行计算。通用服务器采用CPU作为计算能力来源,而AI服务器为异构服务器,可以根据应用范围采用不同的组合方式,如CPUGPU、CPUTPU、CPU其他加速卡等,主要以GPU提供计算能力。从ChatGPT模型计算方式来看,主要特征是采用了并行计算。对比上一代深度学习模型RNN来看,Transformer架构下,AI模型可以为输入序列中的任何字符提供上下文,因此可以一次处理所有输入,而不是一次只处理一个词,从而使得更大规模的参数计算成为可能。而从GPU的计算方式来看,由于GPU采用了数量众多的计算单元和超长的流水线,因此其架构设计较CPU而言,更适合进行大吞吐量的AI并行计算。

深度学习主要进行矩阵向量计算,AI服务器处理效率更高。从ChatGPT模型结构来看,基于Transformer架构,ChatGPT模型采用注意力机制进行文本单词权重赋值,并向前馈神经网络输出数值结果,这一过程需要进行大量向量及张量运算。而AI服务器中往往集成多个AI GPU,AI GPU通常支持多重矩阵运算,例如卷积、池化和激活函数,以加速深度学习算法的运算。因此在人工智能场景下,AI服务器往往较GPU服务器计算效率更高,具备一定应用优势。

AI服务器分类方式有两种:

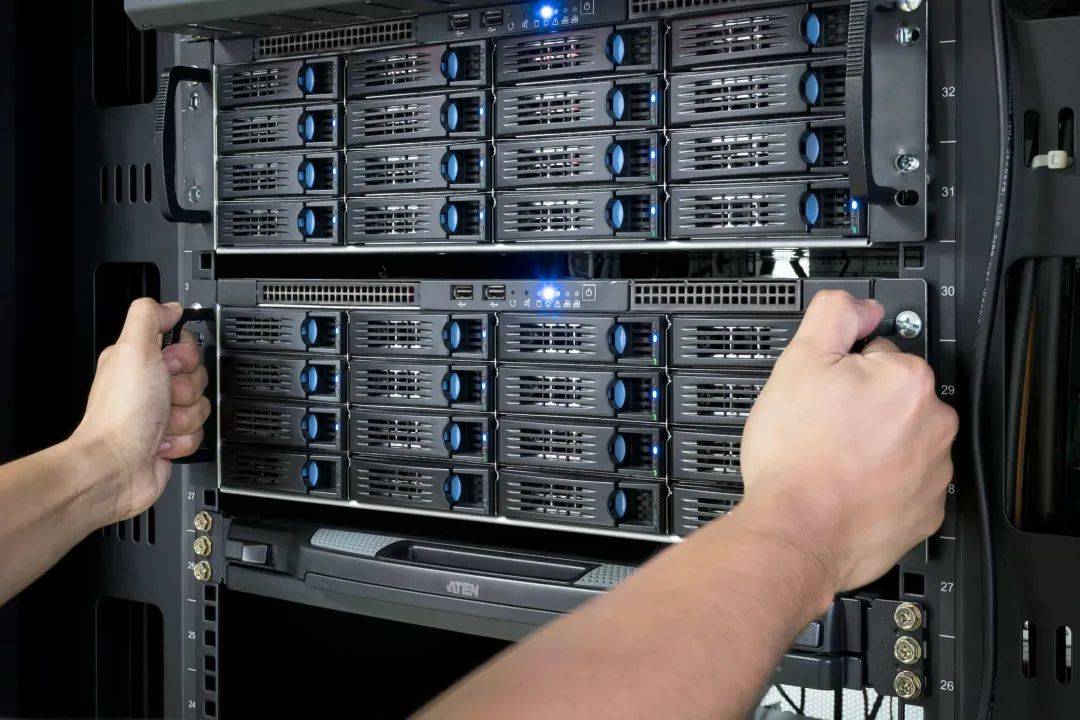

1)按应用场景:AI服务器按照应用场景可以分为深度学习训练型和智能应用推理型。训练任务对服务器算力要求较高,需要训练型服务器提供高密度算力支持,典型产品有中科曙光X785-G30和华为昇腾Atlas 800(型号9000、型号9010)。推理任务则是利用训练后的模型提供服务,对算力无较高要求,典型产品有中科曙光X785-G40和华为昇腾Atlas 800(型号3000、型号3010)。

2)按芯片类型:AI服务器为异构服务器,可以根据应用范围调整计算模块结构,可采用CPU+GPU、CPU+FPGA、CPU+TPU、CPU+ASIC或CPU+多种加速卡等组合形式。目前,产品中最常见的是CPU+多块GPU的方式。

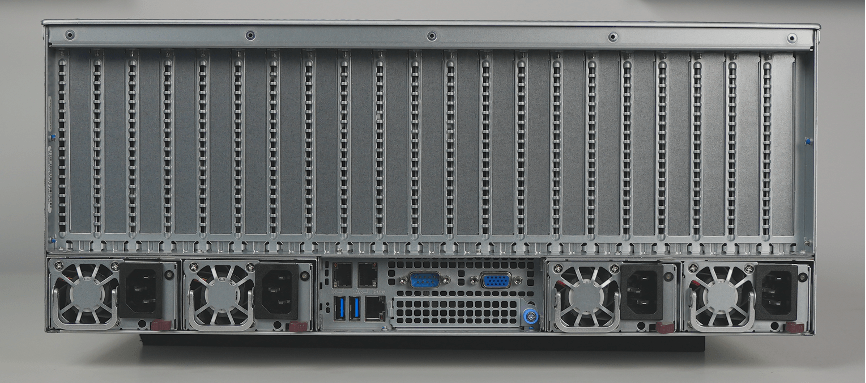

常见的AI服务器分为四路、八路、十六路。一般来说,通用服务器主要采用以CPU为主导的串行架构,更擅长逻辑运算;而AI服务器主要采用加速卡为主导的异构形式,更擅长做大吞吐量的并行计算。按CPU数量,通用服务器可分为双路、四路和八路等。虽然AI服务器一般仅搭载1-2块CPU,但GPU数量显著占优。按GPU数量,AI服务器可以分为四路、八路和十六路服务器,其中搭载8块GPU的八路AI服务器最常见。

AI服务器采用多芯片组合,算力硬件成本更高。我们以典型服务器产品为例拆解硬件构成,可以更清晰地理解两类服务器硬件架构区别:以浪潮通用服务器NF5280M6为例,该服务器采用1~2颗第三代Intel Xeon可扩展处理器,据英特尔官网,每颗CPU售价约64000万元,故该服务器芯片成本约64000~128000;以浪潮AI服务器NF5688M6为例,该服务器采用2颗第三代Intel Xeon可扩展处理器+8颗英伟达A800 GPU的组合,据英伟达官网,每颗A800售价104000元,故该服务器芯片成本约96万元。

5、ChatGPT需要的芯片:CPU+GPU、FPGA、ASIC

GPT模型训练需要大算力支持,或将带来AI服务器建设需求。我们认为,随着国内厂商陆续布局ChatGPT类似产品,GPT大模型预训练、调优及日常运营或将带来大量算力需求,进而带动国内AI服务器市场放量。以GPT-3 175B模型预训练过程为例,据OpenAI,进行一次GPT-3 175B模型的预训练需要的算力约3640 PFlop/s-day。我们假设以浪潮信息目前算力最强的AI服务器NF5688M6(PFlop/s)进行计算,在预训练期限分别为3、5、10天的假设下,单一厂商需采购的AI服务器数量分别为243、146、73台。

AI大模型训练需求火热,智能算力规模增长有望带动AI服务器放量。据IDC数据,以半精度(FP16)运算能力换算,2021年中国智能算力规模约155.2EFLOPS。随着AI模型日益复杂、计算数据量快速增长、人工智能应用场景不断深化,未来国内智能算力规模有望实现快速增长。IDC预计2022年国内智能算力规模将同比增长72.7%至268.0 EFLOPS,预计2026年智能算力规模将达1271.4 EFLOPS,2022-2026年算力规模CAGR将达69.2%。我们认为,AI服务器作为承载智能算力运算的主要基础设施,有望受益于下游需求放量。

下载链接:《92份重磅ChatGPT专业报告》1、计算机研究报告:ChatCPT在金融应用前景 2、ChatGPT系列,重构办公软件价值天花板 3、ChatGPT通用化效果突破、前景广阔 4、ChatGPT系列,为人形机器人注入“灵魂” 5、ChatGPT更懂人类的叙事 6、浙商证券:ChatGPT研究框架 7、ChatGPT芯片算力:研究框架 8、Chiplet方兴未艾,先进封测持续创新(2023) 9、ChatGPT将AIGC推向平民化时代(2023) 10、ChatGPT:AI相关生态赛道会分享 11、AIGC 概念爆火带来什么启示 12、ChatGPT成功连接,未来可期(2023) 13、大厂加大类ChatGPT布局力度,商业应用有望加速落地 14、ChatGPT带来算力需求;第三方支付行业逻辑逐步被认知 15、三分钟看懂ChatGPT 16、ChatGPT跨行业专题报告:AIGC发展大年,推动新一轮产业革命(2023) 17、ChatGPT的背后:指数级增长的芯片与半导体需求(2023) 18、专题研究:ChatGPT:深度拆解(2023) 19、专题报告:AIGC进展迅速,重构内容生产力(2023) 20、ChatGPT热度加速AI算力,光通信产业链受益 21、ChatGPT专题:探寻ChatGPT能力圈,以及破圈之路(2023) 22、AIGC专题:探析AIGC的技术发展和应用(2023) 23、AIGC/ChatGPT:内容生产力的革命(Web3.0) 24、ChatGPT的背后:指数级增长的芯片与半导体需求(2023) 25、国内外科技公司ChatGPT技术布局及应用场景 26、ChatGPT:又一个“人形机器人”主题(2023) 27、揭秘ChatGPT身后的AIGC技术和它的中国同行(2023) 28、ChatGPT 研究框架(2023)--提供pdf/ppt版 29、ChatGPT:真格基金分享(2023) 30、揭秘ChatGPT身后的AIGC技术和它的中国同行(2023) 《ChatGPT专题报告(1)》 31、行业专题研究:ChatGPT,开启AI新纪元(2023) 32、从ChatGPT到生成式AI(Generative AI):人工智能新范式,重新定义生产力(2023) 33、海外ChatGPT专题:ChatGPT风口已至,商业化落地加速(2023) 34、ChatGPT:开启AI新纪元(2023) 35、ChatGPT引领,关注AI产业2023新场景落地 《ChatGPT专题报告(2)》 36、ChatGPT:优化对话的语言模型(2023) 37、ChatGPT:聊天机器人顶流,开启自然语言处理领域新篇章 38、ChatGPT前景广阔,巨头入局有望加速AI落地(2023) 39、ChatGPT:振奋人形机器人应用端锦绣前程 《AIGC人工智能行业专题》 40、AIGC行业专题:2023年有望成为AIGC的拐点 41、腾讯研究院AIGC发展趋势报告2023 42、GPT-1到ChatGPT产业梳理 43、ChatGPT需要何种算力基础设施?44、ChatGPT全球商业化落地加速,新一轮算力储备开启 45、AIGC时代来临,全球 AI 服务器龙头厂商大有可为 《从“上网”到“上算”,由“网络世界至“虚拟现实”系列报告》 46、AI专题报告之一:AIGC 与ChatGPT 正掀起新一轮的产业浪潮 47、AI专题报告之二:AIGC将开启新一轮游戏产业变革 48、AI专题报告之三:新一轮内容爆发的AIGC逻辑,在于消除“认知”不对称 49、ChatGPT开启AI发展新浪潮,算力紧缺和海量应用驱动AI硬件广阔空间 50、ChatGPT对GPU算力的需求测算与相关分析 51、AIGC&ChatGPT发展报告 《华西证券:AIGC行业深度报告》 52、AIGC行业深度报告(1):ChatGPT,开启AI新纪元(2023) 53、AIGC行业深度报告(2):ChatGPT重新定义搜索入口 54、AIGC行业深度报告(3):ChatGPT打响AI算力“军备战” 55、ChatGPT掀起全球热潮,光通信领域有望受益于高算力需求 56、ChatGPT引领 AI 新浪潮,AIGC商业化启程 57、ChatGPT推动AI等高算力场景,IDC 液冷技术应用有望加速 58、ChatGPT开启AI新纪元,AIGC框架梳理 59、海内外ChatGPT相关应用逐步落地,主流媒体再提游戏技术价值 60、ChatGPT 系列报告:算力侧IDC迎来重要机遇 《湘财ChatGPT专题研究系列》 61、ChatGPT专题研究之一:探寻ChatGPT能力圈,以及破圈之路(2023) 62、ChatGPT专题研究之二:算力的提升是人工智能发展的基石 63、ChatGPT狂飙破壁,现象级AI应用引发范式革命 64、从ChatGPT等生成式AI的算力开销及商业化潜力,看微软和谷歌面临的挑战 65、AIGC推动AI产业化由软件向硬件切换,半导体+AI生态逐渐清晰 66、AIGC时代来临,底层AI算力龙头厂商未来可期 67、ChatGPT及类生态爆火,公司潜在需求量增加 68、ChatGPT不断突破,AI驶入快车道 《传媒行业AIGC/ChatGPT报告》 69、传媒行业复苏进行时,关注AIGC时代机遇 70、传媒行业看好AIGC方向,关注Web3概念海外映射 71、ChatGPT加入商业,看好AIGC在游戏、数字人领域应用 72、人工智能行业:ChatGPT对算力需求究竟如何?73、ChatGPT引领,关注AI产业2023新场景落地 74、ChatGPT平地惊雷,AI热潮来袭 75、AIGC深度研究报告:拐点时刻(2023) 76、2023中国AIGC市场研究报告:ChatGPT的技术演进、变革风向与机会分析 77、ChatGPT开启行业变革,Chiplet引领破局之路78、深度报告:AIGC将如何影响传媒行业 79、传媒行业究报告:AIGC引领内容生产方式变革 80、计算机行业:ChatGPT,深度拆解AI算力模型 81、AIGC系列跟踪:应用如何落地 82、ChatGPT开启算力革命,国产生态初现 83、AIGC之AI 绘画:技术与应用双突破,生产力变革在即84、ChatGPT概念发酵,建议关注泛AI产业链85、人机交互新时代:多维度快速看清ChatGPT86、ChatGPT概念解析和市场机会 87、AIGC和ChatGPT,为什么火了?88、ChatGPT有望带来5G消息业务的重构 89、国产类ChatGPT模型MOSS发布,人工90、智能将作为战略性新型产业(2023) 90、探析生成式AI:ChatGPT新浪潮下的算法监管(2023) 91、人工智能:AIGC、ChatGPT(2023) 92、计算机专题研究:ChatGPT服务器,深度拆解本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

电子书<服务器基础知识全解(终极版)>更新完毕,知识点深度讲解,提供182页完整版下载。

获取方式:点击“小程序链接”即可查看182页 PPT可编辑版本和PDF阅读版本详情。服务器基础知识全解PDF(终极版)

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。

不看后悔「ChatGPT服务器,深度拆解(2023)」服务器tpmc指标服务器tpmc 一般为多少