干货分享「Nvidia GTC 2024 跟踪2:服务器/网络设备/存储等主题演讲要点」nvidiageforce是什么牌子nvidiageforceGT730是独立显卡吗

【GTC 2024】面向AI基础设施和网络的创新高性能思科以太网架构会议要点

- Will Eatherton,高级副总裁,Cisco

讨论了带宽需求的巨大增长以及这对网络基础设施的挑战。他指出,单个AI系统的流量可以与美国主要电信公司处理的总移动带宽相媲美,强调了对高性能计算入侵企业领域的担忧和兴奋。

探讨了构建AI和ML网络的复杂性增加,特别是在考虑可能需要专门网络的情况下。Eatherton还讨论了在实现更好的网络以太网、网络内计算以及如何适应AI和ML工作负载方面的关键演化方向。

Cisco的视角强调了管理AI网络的新模型需要,以及如何通过SaaS服务全面自动化基础设施来减少复杂性和提高效率。他提倡统一的网络管理和自动化策略,以便企业能够在本地和云中有效部署AI和ML应用。

讨论如何利用Nvidia的GPU和Cisco的交换技术来实现下一代高性能AI网络。他提出的解决方案旨在为企业提供类似云的AI和ML体验,强调了管理和自动化的重要性。

总结:Will Eatherton强调了AI和ML对网络基础设施带来的挑战和机遇,特别是在处理巨大的带宽需求和增加的网络复杂性方面。Cisco致力于通过与Nvidia的合作和创新以太网技术,提供解决方案来应对这些挑战,同时推动网络管理和自动化的新模型

【GTC 2024】AI_ML-Ready 网络关键要求和网络蓝图 会议要点

- Andy Sholoman, Senior Director, Technical Marketing, Cisco Data Center Networking, Cisco Systems

介绍了Cisco与Nvidia在UCS服务器中集成Nvidia Tensor Core GPU和共同验证的参考架构(CVD)方面的合作,重点在AI/ML就绪网络上。

讨论了通过汇聚以太网上的远程直接内存访问(RDMA over Converged Ethernet, RoCE)技术实现GPU间的直接内存访问,减少通信延迟,提高系统效率。

解释了RoCE技术的发展,从RoCEv1到RoCEv2的演变,后者通过UDP头封装支持跨多个机架的流量路由,增强了网络的可扩展性。

强调构建高效AI/ML网络的四个关键要求:非阻塞设计、超低延迟传输、流量隔离和大型缓冲区。

讨论了使用显式拥塞通知(ECN)、加权随机早期检测(WRED)和优先级流控制(PFC)等技术来构建无损网络,并确保高效、有序的数据传输。

分享了在UCS服务器上配置Nvidia GPU和Mellanox ConnectX-6网卡的细节,以支持PFC和RoCEv2,确保网络和服务器端的无损配置一致性。

介绍Cisco为构建无损RoCE网络提供的验证设计方案和自动化配置脚本,简化了网络和服务器端配置的复杂性。

总结:Andy Sholoman的演讲强调了在构建AI/ML就绪网络时的关键考虑因素和技术要求,突出了Cisco和Nvidia合作的重要性以及有效利用RoCE技术的优势。通过分享具体技术细节和配置建议,他提供了一套完整的蓝图,帮助企业构建高效、无损的以太网AI网络。

【GTC 2024】创新高性能思科以太网架构支持AI基础设施和网络 会议要点

- Will Eatherton, Senior Vice President, Networking Engineering, Cisco

AI系统如Nvidia DGX H100带来极高的网络带宽需求(约10TB),超过一些主要运营商的移动带宽总和。

AI网络增加了复杂性,未来或需三个网络(以太网、存储网、AI专网)共存。

企业AI部署与超大规模部署有所区别,不太可能完全沿用HPC做法。

思科认为以太网将继续主导,并推动其演进满足AI性能需求(如数据包喷洒)。

推荐SONiC作为AI网络操作系统基础。

呼吁新的以太网管理模型,提供端到端自动化、全面覆盖、API集成。

倡导混合云部署,企业在本地和公有云并重。

将采用Nvidia Bluefield-3智能网卡与思科交换机硅芯片相集成。

与Nvidia合作开发"类云"AI网络管理体验,参考Meraki云管理。

总结:强调高性能网络硬件、智能网卡、以太网演进和统一云管理体验,思科阐述了支持AI基础设施网络所需的硬件解决方案蓝图。

【GTC 2024】利用VMware与英伟达联合推出的私有AI基础设施,驾驭AI的强大力量会议要点

- Shobhit Bhutani,VMware by Broadcom 产品营销主管

- Justin Murray,Broadcom 产品营销工程师

生成式AI如GPT带来巨大经济价值,但企业关注隐私、选择性、成本、性能和合规性。

VMware私有AI提供完全私有的大型语言模型,确保数据安全可控,并支持各种基础模型选择。

关键用例包括代码生成、联络中心解决方案、IT运维自动化和高级信息检索。

VMware Cloud Foundation为基础设施,提供深度学习VM模板和自助服务目录。

与Nvidia合作,集成GPU运算符、推理微服务、向量数据库(PG Vector)等组件。

演示了最终用户RAG应用、深度学习VM环境和Aria自动化工具,展示了端到端体验。

联合解决方案旨在为企业提供高性能、隐私且灵活可选的生成式AI基础架构。

总结:概括了VMware和Nvidia联合解决方案的主要内容,包括背景、架构、组件以及相关的演示环节,覆盖了人工智能、硬件、数据中心等相关领域。

【GTC 2024】加速AI数据管道:25PB分层存储案例研究 会议要点

- William Li,Supermicro解决方案管理总监

- Paolo Basilio,Supermicro高级存储架构师

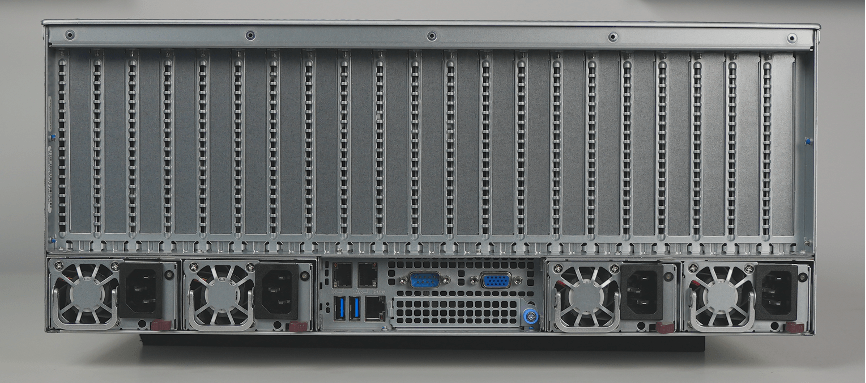

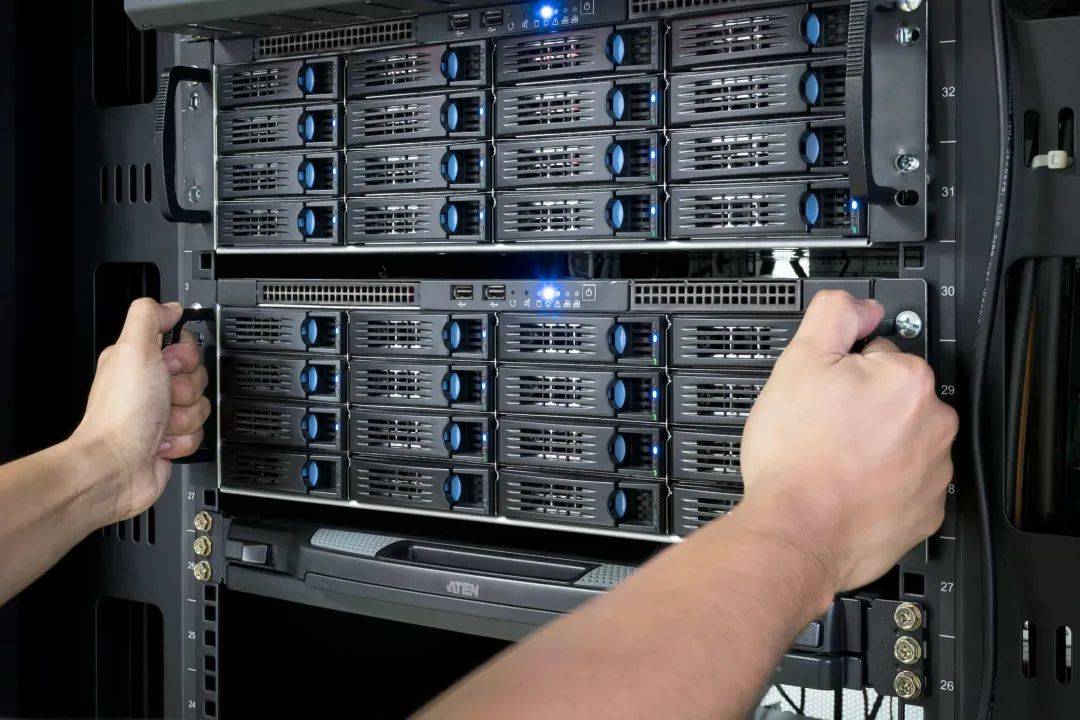

AI应用对存储系统提出更高性能和复杂工作负载要求,Supermicro通过架构和硬件解决方案应对25PB数据集挑战。

采用分层存储架构,将数据重要性与正确处理关联,利用GPU直连存储提高效率。

提供两种可扩展AI应用参考架构,包括分层层和高性能存储层,由SGX系统等Supermicro组件构建。

实验室数据显示存储解决方案吞吐量远超Nvidia建议值,对象存储实践包括CPU资源分配和驱动器配置。

支持AI的存储节点包括高容量可扩展解决方案,通过添加MVME设备或新系统扩展容量。

混合IO模式影响AI数据管道,Supermicro解决方案有效管理数据,结合存储系统和软件定义存储优势。

总结:介绍了Supermicro的分层存储架构和硬件解决方案,以应对AI数据管道中25PB规模数据集的存储和管理挑战,展示了高性能、可扩展性和最佳实践。

【GTC 2024】第五代高带宽内存对生成式人工智能系统的价值主张 会议要点

- Hyun Hwang,技术领导,SK hynix

SK hynix 强调了HBM(高带宽存储器)在提高生成AI和高性能计算(HPC)性能方面的价值,包括其竞争优势、经济价值以及对市场的影响。

展示了HBM技术的发展历程,特别是HBM3E的性能提升,包括与HBM3相比提高的密度、带宽和功耗效率。

讨论了HBM市场的增长趋势,特别是在生成AI应用中的增长预期,以及这对HBM技术需求的影响。

详细介绍了HBM3E的设计优势,包括提高的性能、经济效益和兼容性,以及对未来产品如HBM4的展望。

SK hynix在HBM技术上的创新,例如包装技术的进步,以及这些创新如何提高产品性能和热特性。

强调了SK hynix在推动HBM技术进步方面的领导地位,以及其对满足日益增长的生成AI和HPC需求的承诺。

总结:SK hynix在GTC 2024上强调了其HBM技术在生成AI系统和高性能计算领域的核心价值,展示了技术发展、市场趋势和未来目标。通过不断的创新和技术进步,SK hynix旨在提升HBM的性能和经济效益,以支持日益增长的数据处理需求。

【GTC 2024】支持人工智能的下一代互连技术 会议要点

- Sam Kocsis, Amphenol通信解决方案公司标准与技术总监

互连技术在数据中心向AI时代转型中扮演关键角色,为高性能计算、AI和机器学习部署提供低功耗、低延迟和高带宽的连接。

标准化平台、子系统、形式因素和协议有助于促进互连解决方案的兼容性和互操作性。

过去10年,以太网和铜缆互连技术不断提高带宽,但物理覆盖范围减小,需要新的调制方案和硅架构支持。

Amphenol支持灵活拓扑,提供Card Edge Mechanical、Chem Connector、EDSFF、Mini Cool Edge IO等标准化接口。PCI SIG推动模块化架构和低延迟计算应用。

PCI SIG致力于光互连标准化,Amphenol展示了光学收发器卡和支持铜光混合的新架构。

优化机械接口设计有助于支持更高数据速率和互连密度,需考虑网络元素要求。

电缆到板互连解决方案逐步取代传统背板结构,支持灵活引脚配置和服务性。

总结:涵盖人工智能、互连、硬件、半导体器件等相关领域,讲解人工智能的下一代互联技术发展趋势和要求。

【GTC 2024】使用 NVIDIA Omniverse 的面向 6G 应用的光线追踪射频传播数字孪生解决方案 会议要点

-Jukka Kyrolainen,研发经理,Keysight

介绍了利用 NVIDIA Omniverse 平台进行光线追踪的射频传播数字孪生解决方案,以支持 6G 应用的开发。

通过实例展示了数字孪生如何为高精度的射频传播提供模拟,利用光线追踪技术反映不同传播相互作用对信号的影响。

讨论了 6G 环境中对信道模型提出的新要求,如更高的带宽、更高频率的使用,以及 AI 在增强无线系统功能和测试过程中的应用。

强调了利用 NVIDIA Omniverse 构建数字孪生模型的创新工作流程,包括 AI 辅助信道建模,以及这些技术如何支持大规模数据集的创建,用于 AI 训练和验证。

展示了两个示例用例:一个是智慧城市场景中的 5G 和 6G 信号传播模拟,另一个是利用通信网络进行对象感知的应用。

讨论了当前光线追踪技术在 3GPP 标准化进程中的地位和未来发展可能,以及为什么目前该技术还未被广泛采用。

小总结:详细介绍了使用 NVIDIA Omniverse 平台和光线追踪技术进行的射频传播数字孪生解决方案,这些解决方案旨在支持 6G 应用的开发。通过实际示例展示了数字孪生模型如何模拟复杂的射频环境,以及 AI 如何用于增强信道建模和系统测试。

【GTC 2024】探讨液冷技术在AI时代数据中心的影响 会议要点

- Mitchell Knight,CoolIT Systems 产品管理总监

人工智能加速器的热设计功率(TDP)在过去两年中几乎翻番,推动了数据中心机架密度快速增长。预计AI时代数据中心平均机架功率密度将达到45kW,个别热点可能高达110kW。

直接液冷(Direct Liquid Cooling)技术被认为是支持高密度AI工作负载的最有效热管理方案。CoolIT是该领域的市场和技术领导者,提供端到端的液冷解决方案。

CoolIT的液冷产品包括:专利微通道冷板、机架级分流器和冷却分布单元(CDU)等。CDU可分为空气热交换器(AHx)型和水冷式(CHx)型。

案例1:德国Emmy超算采用风冷和液冷混合方式,数据显示液冷机架效率和可持续性更高。

案例2:瑞典SWE01数据中心采用35-40°C温水直接液冷技术,能将85%的消耗电力转化为区域供热,为2万户家庭供暖。

总结:液冷技术有助于实现高密度、高效、可持续的AI时代数据中心,符合人工智能、硬件、半导体、数据中心、可持续能源等相关领域的发展趋势。

【GTC 2024】工厂的未来:用先进工人模拟改变工作设计 会议要点

- Lars Fritzsche, CEO, imk Industrial Intelligence GmbH

Lars Fritzsche展示了通过先进人类工人模拟技术改变工作设计,展望工厂未来。

回顾了宝马(BMW)和梅赛德斯-奔驰(Mercedes-Benz)等公司应用模拟技术优化生产流程的历史。

介绍了EMA工厂设计和工作设计两部分组成的软件,适用于规划工作站布局、生产流程等,全球约40家公司和55所大学使用。

从简单模型到医学级别的详细模型,展示了虚拟建模如何帮助进行精确的工作流程设计和评估。

通过案例展示EMA软件在电动汽车装配线优化、农业机械组装工作单元设计,以及生产迁移中的应用成效。

介绍了EMA从2007年原型到现成商业产品的演变,以及与宝马等公司的合作过程。

总结:凸显了利用人类工人模拟技术在提高工厂生产效率和安全性方面的潜力,EMA软件作为此领域的关键进展,展现了工业自动化和数字化转型的前景。

【GTC 2024】存储服务对人工智能_ML 和数据分析的价值 会议要点- Sarah Peach, Senior Director, Product Management, Samsung Semiconductor

企业数据的增长速度是消费者数据的两倍多,高性能数据存储已成为SaaS企业客户的必备条件。

市场对以云原生方式消费的存储产生了强烈需求,这些存储服务基于服务且位置无关,以支持AI和分析工作负载。

Opsara提供云相邻基础设施服务,帮助SaaS和企业客户通过混合云解决方案满足增强性能要求并降低总拥有成本。

通过采用云原生设计方法和优先考虑边缘位置,最小化所需的数据移动,从而降低成本并提升性能。

利用三星PB SSD的性能,选择使用NVMe over TCP作为存储访问协议,提供高于iSCSI的性能。

监控云原生存储解决方案:通过集成的监控系统来监控整个存储环境,包括容量、I/O性能指标和冗余容错功能。

云服务提供商对存储硬件的需求:选择性能、数据持久性、可观测性和可扩展性均衡的存储解决方案。

Opsara为SaaS和企业公司的CIO提供快速部署、性能优化和成本节约的解决方案,使他们能够脱颖而出。

总结:强调了存储即服务(Storage-as-a-Service)在AI/ML和数据分析中的重要价值,特别是在支持数据密集型工作负载和优化性能及成本方面的作用。

【GTC 2024】用OpenUSD为企业解锁工业元宇宙 会议要点- Marc Herrlich, Senior Consultant, T-Systems

工业元宇宙与消费元宇宙的区别在于前者更注重实现具体的业务案例和应用,如提高产品开发效率、加速上市时间和生产效率。

OpenUSD是由Pixar开发的一种开放标准,用于描述3D资产。它支持非线性和非破坏性的工作流和协作,是Nvidia Omniverse的本地格式,已被广泛采用。

OpenUSD的关键特性包括其开放性、API支持、组合艺术能力,允许高效组合和修改场景,同时支持元信息和过程信息的集成。

OpenUSD的核心概念包括Prim、变换、引用、变体集和有效载荷,这些概念为用户提供了灵活的数据处理和场景构建工具。

实际应用案例包括汽车行业中的产品认证加速、虚拟工厂和数字孪生的管理与优化。

T-Systems正在开发的工具和系统旨在简化OpenUSD的使用和集成,包括PDM Web连接器、Stagemaker和Stage Explorer。

建议重视建立可靠的数据集成架构,并在使用OpenUSD时充分利用其核心功能,如有效载荷和变体集。

Marc Herrlich鼓励听众积极参与OpenUSD的发展和探索,为企业解锁工业元宇宙的潜力。

总结:强调了利用OpenUSD为企业开启工业元宇宙的价值,通过介绍OpenUSD的特性、核心概念以及实际应用案例,展示了其在提升业务效率和加速创新中的重要作用。同时,演讲中提到的工具和系统展示了T-Systems对于简化OpenUSD集成和使用的承诺,以及为企业提供的技术支持和合作机会。

【GTC 2024】将 CUDA Quantum 与量子计算机集成 会议要点- Vladimir Kukushkin, 量子计算机控制软件首席工程师,IQM Quantum Computers

介绍了IQM Quantum Computers与CUDA Quantum的集成,使得在真实量子计算机上执行CUDA Quantum程序成为可能。

大多数现有的量子计算框架都是基于Python的,例如Qiskit、Cirq等,这些框架适合研究环境但存在效率低下和维护难度等问题。

CUDA Quantum作为一个开源项目,采用了不同的方法,实现了C++混合量子-经典系统,并提供了Python封装,以便编写、测试、调试和分发混合量子-经典程序。

介绍了CUDA Quantum的工作流程,包括编译和运行两个阶段,并强调了其性能优势和分发便利性。

详述了如何将其他量子硬件及其控制软件与CUDA Quantum集成,以及如何贡献代码以支持新的量子硬件后端。

讨论了量子计算机控制软件与CUDA Quantum集成的实际性,特别是在教育和研究开发中使用IQM Spark设备的可能性。

总结:Vladimir Kukushkin展示了CUDA Quantum如何为量子计算提供一个高效且易于维护的编程和执行平台。通过与CUDA Quantum的集成,IQM Quantum Computers能够提供一种新的方法来编写、测试和执行量子程序,这不仅提高了性能,还简化了量子程序的分发。CUDA Quantum的引入为量子计算领域的软件工程实践和工具引入了新的可能性,特别是在面向未来的量子应用开发和量子计算机硬件测试中。

【GTC 2024】利用全面液体冷却解决方案激活人工智能基础架构,实现密度和效率上的突破 会议要点- Nathan Mallamace, 战略业务开发经理 & Jae Lee, 热能解决方案产品经理, Supermicro

Nathan Mallamace和Jae Lee讨论了液体冷却技术对于激活AI基础架构、提高数据中心密度和效率的重要性。

随着数据中心功率需求的增加,传统的冷却方法已经无法满足高性能计算硬件的散热需求,这促使了液体冷却技术的采用。

Supermicro预测,到2032年,液冷市场的增长将超过400%,显示出巨大的市场潜力。

Jae Lee通过比喻解释了数据中心液冷系统的组成部分,包括冷却塔(肺)、冷却分配单元CDU(心脏)、冷却分配歧管CDM(动脉)和冷板(重要器官)。

Supermicro的CDU单元设计具有高达100千瓦的额定功率和冗余泵系统,保证了高效和可靠的散热。

冷板直接从芯片吸收热量,是高性能散热的关键部分,Supermicro持续优化其设计以提供最佳性能。

Supermicro的冷却解决方案强调简化的部署和高效的能源利用,推荐供应32°C(约90°F)的水以提高系统效率。

液冷技术不仅提高了系统的散热性能,还能大幅降低数据中心的运营成本(OpEx),在五年的周期内可能节省数百万美元。

Supermicro为从单个液冷机架到整个AI吊舱集群提供定制的液冷解决方案,支持从小规模到大规模的部署。

通过大规模部署液冷技术,Supermicro正在领导数据中心冷却技术的未来,满足最苛刻的AI和高性能计算应用的需求。

总结:Supermicro通过全面的液体冷却解决方案,为AI基础架构带来了密度和效率上的重大突破。随着数据中心对高功率计算需求的增加,液冷技术成为满足这一需求、提高性能同时降低运营成本的关键。Supermicro的创新设计和强大的液冷产品线确保了其在提供高效、可靠和定制化冷却方案方面的领先地位。

【GTC 2024】诞生于工业元宇宙、由OpenUSD支持的智能机器人 会议要点- Cristian Satori, 国家业务部经理

- Vincenzo De Paola, 人工智能技术销售支持, 西门子

分享了如何结合先进的自动化、机器人技术和AI技术来满足制造业对灵活性和模块化的需求。他们探讨了从大规模生产到个性化生产的转变,强调了在保持相同成本和质量水平的同时,应对低批量、高混合生产的挑战。

随着消费者对个性化产品的需求增加,制造业需要转向更灵活、能够快速响应新客户需求的生产方式。这种趋势促使EPF等公司开发了基于工业元宇宙和OpenUSD的智能机器人解决方案,以满足这些需求。

介绍了EPF与西门子和NVIDIA合作,利用AI和机器人技术创造Superta——一种智能给料机。这种解决方案通过利用基于AI的视觉系统,能够处理多种类型的组件,并且易于适应尺寸变化。

西门子通过提供强大的工业PC支持,执行AI算法,并通过Omniverse驱动的工业元宇宙,创建机器的数字模拟,优化制造过程。

探索了工业元宇宙如何为制造业带来变革,特别是通过OpenUSD标准,促进不同领域专家之间的协作,实现设计过程的优化。

总结: 随着制造业向个性化生产的转变,智能机器人和工业元宇宙成为满足这些新需求的关键。展示了技术如何使制造过程更加灵活、高效,并开启了制造业的新时代。

【GTC 2024】引领未来:实时三维和人工智能在汽车行业的创新应用 会议要点- Zhou Huang, 高级总监, Lotus Tech

在汽车行业中,实时3D技术和人工智能(AI)的应用正在引发一场创新革命。Lotus 利用Omniverse平台管理3D资产并促进协作,推动产品在数字世界中的高品质呈现。

Lotus开发了一个内部3D资产协同管理平台,支持从设计到研发阶段的资产整合。通过对材质、模型和场景的分类和优化,支持销售、智能座舱和自动驾驶等应用场景的需求。

Lotus自研了数字孪生工厂,整合了IoT平台数据,实现生产过程的数字化还原和监控。利用深度学习,公司还开发了AI视觉检测技术,用于生产过程中的质量控制。

数字人的智能化程度应用于销售辅助、生产讲解等多个场景。

结合数字人和大语言模型,实现了产品讲解和智能选配。数字人导购能够跨越语言和文化障碍,为不同背景的客户提供服务,提升购车体验。

总结:Lotus正在通过利用Omniverse平台和自研的3D资产协同管理平台,推动产品设计、研发、销售和生产过程的数字化转型和高品质呈现,实现了跨语言和文化的智能产品讲解和选配,极大地提升了购车体验和生产质量控制。

【GTC 2024】开放世界中的一般能力代理人 会议要点- Jim Fan, Research Scientist, NVIDIA

提出了关于开放世界中一般能力代理人(AGI)的愿景和挑战。目标创建能在更复杂、不确定的环境中工作的 AGI,需要跨越技能数量、控制的体现以及掌握的现实的多个维度。

成立 Gear Lab,专注于开发能够在开放世界中导航、探索和学习的智能代理。他认为,成功的关键在于创建一个开放的环境(如 Minecraft),收集大量预训练数据,以及构建一个能将这些数据转化为可行洞察的可扩展基础模型。

进一步探讨了“旅行者”(Voyager)和“变形”(Metamorph)两个项目,分别强调了在 Minecraft 中的自主探索和跨多种机器人身体形态的能力。他强调了将这些技术应用到模拟和物理世界的重要性,以及通过 Isaac Sim 等工具加速模拟训练的潜力。

Fan 的愿景是通过混合 AI 技术(包括大语言模型和强化学习)开发出可以执行多样任务、适应不同身体和在复杂环境中工作的 AGI。

总结:提出未来愿景,希望能够跨越 AGI 的多个维度,最终实现一个能在任何环境中工作、适应任何任务的智能代理。他的工作不仅强调了 AI 研究的技术挑战,也提出了关于 AGI 如何适应和改善我们世界的愿景。

【GTC 2024】加速医疗AI在医疗保健环境中的应用 会议要点

- Haris Shuab, Newtons Tree 公司CEO

医疗保健系统面临可持续性挑战,包括劳动力危机、创新成本不断增加以及健康效果增长缓慢。

当前正值医疗<人工智能>发展的关键时期,有600多种FDA批准的商业医疗AI应用可解决这些挑战,但采用仍面临报销、基础设施、工作流程整合等障碍。

采用医疗AI需要解决技术债务、数据互操作性(半导体、等IT供应商)以及证据生成等挑战,目前医院难以获得AI采用的良好商业案例。

优化基础架构(本地或云端<硬件>)是应对挑战的第一步,新兴的医疗AI操作系统Monei(Nvidia GTC)旨在标准化部署流程。

Newtons Tree围绕Monei构建平台,通过网关、工作流管理器等组件实现跨医疗系统的AI模型部署和集成。

该平台为医疗机构和AI供应商提供AI应用评估、管理和监控的标准化解决方案,缩短销售周期,形成强大的网络效应。

该方案已在RSA成像AI实践演示中展现与诊断工作流程的集成能力,展示了与IT供应商和AI开发商合作的可行性。

总结:会议介绍了AI在医疗环境中应用的重要性和挑战,强调了医疗保健系统面临的不可持续性问题,以及医疗AI可以如何帮助克服这些问题。同时指出了医疗AI采用过程中存在的挑战,并提出了基于平台的解决方案来简化部署、管理技术债务、提高概率,以及生成必要的证据。通过介绍Newtons Tree平台和与之相关的工作,施雷夫展示了如何通过技术和标准化提高医疗AI应用的采用率,同时减少与部署相关的复杂性和风险。

本文源自券商研报精选

干货分享「Nvidia GTC 2024 跟踪2:服务器/网络设备/存储等主题演讲要点」nvidiageforce是什么牌子nvidiageforceGT730是独立显卡吗